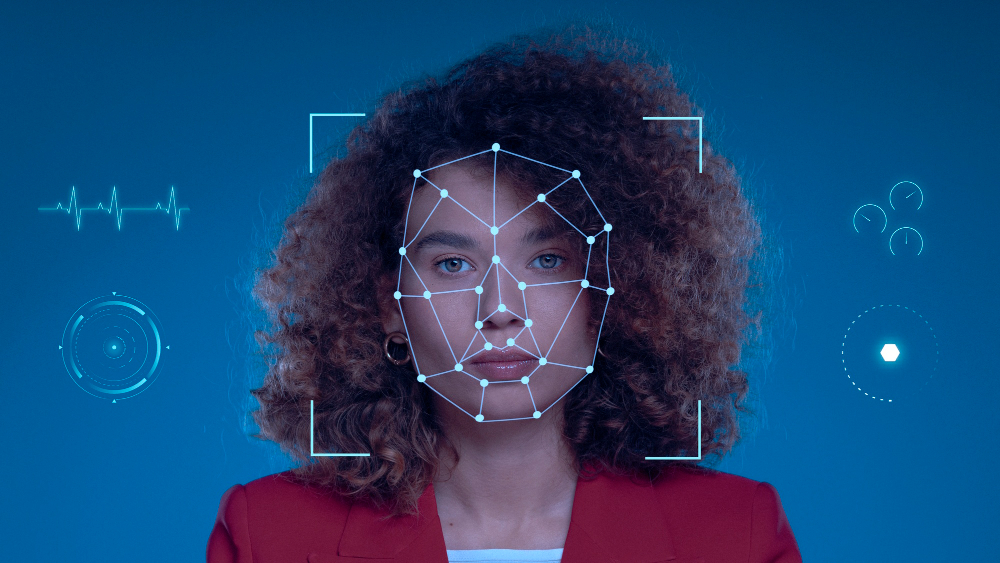

A discussão sobre racismo algorítmico tem destacado como tecnologias aparentemente neutras podem intensificar desigualdades sociais e raciais. Um exemplo preocupante é o uso de sistemas de reconhecimento facial, que têm mostrado um viés significativo contra pessoas negras, especialmente mulheres e pessoas trans.

Em julho de 2022, o mandato da deputada federal Carol Dartora (PT-PR) protocolou o Projeto de Lei 005.00138.2022, restringindo o uso de tecnologias de reconhecimento facial pelo Poder Público para segurança pública e identificação em massa de cidadãos em espaços públicos. O projeto de lei foi protocolado por mais de 50 parlamentares em todo o país e agora está em tramitação na Câmara Municipal de Curitiba. Com a sua migração para a Câmara Federal, Carol Dartora convidou vereadoras (es) parceiras (os) para subscrever o projeto, assegurando sua continuidade na tramitação legislativa.

“Os sistemas de reconhecimento facial, promovidos como avanços tecnológicos, têm mostrado um viés preocupante contra a população negra. Esses algoritmos, treinados com dados enviesados e desenvolvidos por equipes pouco diversas, perpetuam estereótipos racistas e ampliam desigualdades. A falta de precisão na identificação de pessoas negras, especialmente mulheres e pessoas trans, resulta em graves injustiças, como prisões indevidas e vigilância excessiva,” ressaltou a parlamentar.

Este projeto evidencia um consenso multipartidário sobre o caráter invasivo e discriminatório dessa tecnologia, especialmente quando usada sob pretexto de segurança pública. Para Carol, é crucial que sociedade civil e legisladores se unam para garantir transparência e responsabilidade na implementação dessas tecnologias, protegendo direitos civis e promovendo aplicação mais justa e ética da tecnologia.

Além de evidenciar o racismo inerente a essa tecnologia, o reconhecimento facial coleta dados sensíveis, incluindo informações de crianças e adolescentes, sem autorização. Esses dados podem ser usados em fraudes e outros fins maliciosos e, se vazados, não podem ser redefinidos como senhas. “Precisamos de debate inclusivo e fundamentado para que avanço tecnológico beneficie a todos de forma equitativa e não perpetue injustiças históricas,” finaliza Carol Dartora.

No ano passado, Carol Dartora se reuniu com a sociedade civil e com os mandatos de Henrique Vieira (PSOL-RJ), Talíria Petrone (PSOL-RJ), Erika Hilton (PSOL-SP) e Dani Monteiro (PSOL-RJ) para debater a implementação de reconhecimento facial em espaços públicos e na segurança pública. Carol e o pastor Henrique foram os idealizadores do encontro.

O racismo algorítmico no reconhecimento facial é um problema complexo que exige abordagem multifacetada, com mudanças tecnológicas, regulatórias e culturais. É imperativo assegurar que esses avanços não aprofundem desigualdades, mas contribuam para um futuro mais justo e inclusivo para todos.

Inteligência artificial

O Projeto de Lei 2338/2023 tem despertado debates acalorados devido à sua proposta de regulamentação do uso de reconhecimento facial no Brasil. Enquanto defensores argumentam que a tecnologia pode fortalecer a segurança pública e simplificar processos burocráticos, críticos levantam sérias preocupações quanto ao potencial de discriminação racial embutido nos algoritmos. Estudos mostram que sistemas de reconhecimento facial frequentemente cometem erros desproporcionais ao identificar pessoas de diferentes etnias, expondo uma falha significativa que pode perpetuar o racismo estrutural ao invés de mitigá-lo.

A questão torna-se ainda mais urgente diante do contexto brasileiro, onde a desigualdade racial é um problema persistente. Se não forem adotadas medidas rigorosas para garantir a precisão e equidade dos algoritmos utilizados, o PL 2338 pode inadvertidamente ampliar as disparidades sociais ao invés de promover a justiça e a segurança para todos os cidadãos. O debate sobre a regulamentação do reconhecimento facial, portanto, não se resume apenas a questões técnicas, mas envolve diretamente o combate ao racismo sistêmico que permeia as estruturas sociais e tecnológicas do país.

Capital tecnológica

A questão do racismo do algoritmo ganha relevância também em Recife, especialmente à medida que a cidade adota tecnologias como os relógios inteligentes em seu cotidiano urbano. Estes dispositivos, apesar de suas vantagens em termos de conectividade e praticidade, não estão isentos de reproduzir viéses inconscientes que perpetuam o racismo estrutural. Algoritmos utilizados para reconhecimento facial ou análise de dados de saúde podem apresentar falhas ao identificar ou interpretar informações de pessoas de diferentes etnias, ampliando disparidades já existentes e prejudicando a precisão das análises.

Como centro urbano diverso, Recife enfrenta o desafio de garantir que a adoção de tecnologias como os relógios inteligentes seja acompanhada por políticas e regulamentações que mitiguem o potencial impacto negativo desses algoritmos. Isso requer não apenas a conscientização sobre os riscos do viés algorítmico, mas também a implementação de práticas de desenvolvimento ético e inclusivo que assegurem que todos os cidadãos, independentemente de sua etnia, se beneficiem igualmente das inovações tecnológicas emergentes na cidade.

Proibição mundial

A proibição do reconhecimento facial em espaços públicos é tendência mundial. São Francisco, Boston e Cambridge, entre outras cidades, já baniram essa tecnologia, evidenciando preocupação global com seus impactos.

Estudos acadêmicos revelam que sistemas de reconhecimento facial têm precisão muito menor ao identificar pessoas negras, comparadas a brancas. A pesquisa “Gender Shades”, do MIT Media Lab, mostrou taxas de erro de até 34,7% para mulheres negras, enquanto para homens brancos é cerca de 0,8%.

Os “vícios” nos sistemas informatizados têm diversas causas, incluindo o treinamento com dados históricos enviesados e a falta de avaliação crítica das decisões algorítmicas, perpetuando estereótipos racistas. Quando os dados históricos refletem preconceitos do sistema de justiça, os algoritmos podem aprender e reproduzir esses vieses, resultando em decisões mais severas e vigilância mais intensa para certos grupos étnicos. O perfilamento racial impacta a replicação de práticas racistas, onde sistemas de vigilância podem correlacionar características raciais com alto risco, levando a tratamentos mais rigorosos para grupos minoritários.

Sistemas de vigilância preditiva também são afetados por vieses raciais, direcionando mais recursos de vigilância a comunidades habitadas por minorias, aumentando a presença policial e as chances de prisões. Decisões judiciais podem ser influenciadas negativamente por algoritmos que consideram erroneamente certos comportamentos como indicadores de maior periculosidade, resultando em sentenças mais severas para grupos específicos. A falta de diversidade nas equipes de desenvolvimento também contribui para reconhecimentos enviesados, pois equipes não diversas podem não considerar diferentes perspectivas e experiências, aumentando o risco de incorporar vieses involuntários.

Consequências sociais e legais

O impacto desse viés algorítmico é profundo. Casos de identificação incorreta podem levar a consequências graves, como prisões injustas. No início deste ano, duas pessoas foram libertadas após serem presas indevidamente por um sistema de reconhecimento facial no Rio de Janeiro, devido a mandados de prisão já revogados que não foram atualizados nos sistemas. Esses incidentes levantam questões sobre a eficiência dos sistemas de reconhecimento facial no âmbito criminal. Um dos principais problemas é o erro nas informações inseridas nos sistemas. Esse problema ficou evidente logo no início do uso da tecnologia, quando 2 das 4 primeiras prisões realizadas foram irregulares.

Em abril, ocorreu a prisão errônea de João Antônio Trindade durante um jogo de futebol em Sergipe, devido a um erro no sistema de reconhecimento facial da polícia, gerou um debate sobre o uso da tecnologia na aplicação da lei. Grupos de direitos humanos alertam que tais sistemas podem violar direitos fundamentais e aumentar a discriminação contra minorias. Após o incidente, Trindade, presente na final do Campeonato Sergipano entre Confiança e Sergipe, foi algemado e levado para interrogatório, relatando constrangimento e indignação nas redes sociais. Em resposta, o governo de Sergipe suspendeu temporariamente o uso dessa tecnologia.

Busca por soluções

Diante desses desafios, especialistas e ativistas têm clamado por maior transparência e responsabilidade na criação e implementação de tecnologias de reconhecimento facial. Empresas de tecnologia estão sendo pressionadas a melhorar a diversidade de seus conjuntos de dados e a implementar medidas rigorosas de auditoria para detectar e corrigir vieses.

No Brasil, a discussão sobre racismo algorítmico e reconhecimento facial ainda está em seus estágios iniciais, mas é crucial que a sociedade civil, os legisladores e as empresas de tecnologia estejam atentos e engajados. Promover um debate inclusivo e fundamentado sobre o tema é essencial para garantir que o avanço tecnológico beneficie a todos de forma equitativa e não perpetue injustiças históricas.

Já nos EUA, alguns locais, como São Francisco e Boston, já começaram a tomar medidas legislativas para restringir ou proibir o uso de reconhecimento facial por forças policiais. Essas ações representam passos importantes para a proteção dos direitos civis e para a promoção de uma aplicação mais justa e ética da tecnologia.